- 2015-06-30

- ツイート

フロントランナーVol.46

最先端を走る日本の音声翻訳技術

「言葉の壁」を取り払い世界を変える

奈良先端科学技術大学院大学 教授 中村 哲

1958年生まれ。京都工芸繊維大学卒業後、シャープ入社。86年、国際電気通信基礎技術研究所(ATR)に出向し音声認識、自動翻訳の研究に携わる(~89年)。92年京都大学工学博士、94年奈良先端科学技術大学院大学助教授に就任、2000年にATRに戻り音声言語研究所室長(のち音声言語コミュニケーション研究所所長)。情報通信研究機構けいはんな研究所所長を経て、2011年より現職。日本における音声翻訳の第一人者で、総理大臣表彰や文部科学大臣表彰など数多くの賞を受賞。

テキスト翻訳より難しい音声翻訳を研究

ドラえもんのひみつ道具のなかで一番欲しいものは何? あるポータルサイトが実施したアンケートでは、1位は「どこでもドア」、さらに「タケコプター」「タイムマシン」「ほんやくコンニャク」がそれに続いた。1位から3位までの実現の可能性は、現在のところ低いと見られている。一方、4位の「ほんやくコンニャク」は実用化が視野に入ってきた。もちろん、何かを口にするわけではない。パソコンやスマホなど道具を使って異なる言語間で会話をするというものだ。自動翻訳の技術は、どこまで進んでいるのだろう。越えるべき課題は何か。研究の最前線を中村教授に聞いた。

みなさんは、英語の勉強は好きですか? グローバル時代の現在では英語は「必須のツール」です。しっかり学校で勉強しましょう。そして、英語を使って世界中の人たちと交流できるようになってください。ただし、世界には英語以外にもさまざまな言語が存在します。一説には7000近くになるといわれ、むしろ英語が通じない地域のほうが多い。そんな土地の人たちとも自由に会話ができたら楽しいでしょうね。それこそ、ドラえもんの「ほんやくコンニャク」のようなものがあれば、どれだけ便利でしょう。

まさに私は、この「ほんやくコンニャク」のようなものを研究しているんです。

パソコンなど機械を使った翻訳(=自動翻訳)は大きく「テキスト翻訳」と「音声翻訳」の2つに分けることができます。テキスト翻訳はA言語で文字になった文章をそれとは別のB言語に変えるもので、すでにインターネット上では数多くのテキスト翻訳サービスが提供されています。無料で使えるものでも、精度はかなり高くなりました。一方、音声翻訳はある言語で話した音声を別の音声に変換します。要するに、機械を使って異なる言語間で会話をする技術です。

実は音声翻訳は、テキスト翻訳に比べて数段難しい。そして、私が取り組んでいるのはこの音声翻訳のほうで、かれこれ30年近く研究にかかわっています。

音声翻訳が難しいのは、構成要素が多いからです。構成要素は3つあり、それぞれ異なった技術が必要になります。まず、話した言葉を正しく機械が認識しなくてはいけません(=音声認識)。次に、その認識した内容を自動的に相手の言語に変換します(=機械翻訳)。最後に、翻訳した内容を音声として出力(=音声合成)――。出だしの音声認識からして難問山積なんですね。というのも、話し手によって言葉の使い方は異なりますし、そのときどきで声の調子も微妙に違うからです。

「私が勤める大学は奈良にあります」、この程度の短い文章を認識するだけでも簡単ではありません。詳しくはお話ししませんが、ある種の確率モデルや、単語同士の関係を蓄積した言語モデルを駆使して探り出しています。そして、「nara ni aru」を「奈良にある」という具合に漢字と仮名に正しく変換。「橋」と「箸」、「機械」と「機会」など同音異義語もこれらの手法で判別します。

2番目の機械翻訳は、文法をもとに翻訳していく手法が従来、取られていました。ところが会話の場合、少々文法的におかしな文章でも「成り立つ」からやっかい。書かれたものと違って句読点や疑問符など、文章の意味を捉えるための情報もありません。それでも、私たちは場の雰囲気や前後の文脈などから判断するのですが、機械はそうはいかない。そこで、いまでは同じ意味をもつ異なる言語の例(対訳用例)から似たようなケースを探し出す手法に変わってきました。日本から始まった技術ですが、さらに統計モデルが導入され、格段に翻訳力が向上しています。最後の音声合成も、イントネーションや人間の声を生成するメカニズムを考慮しながら合成する手法が研究・開発されて、違和感なく聞くことができるレベルに近づいています。

いずれにしても、分析のもとになる対訳用例などデータの蓄積、機械学習の一種である認識や翻訳の統計モデリング、そして膨大なデータを迅速に処理する方法の確立と処理する機械の性能向上などがカギになるわけです。

スマホが「ほんやくコンニャク」の役割を果たす時代は間もなく訪れる

「日本語から英語」に立ちはだかる語順の壁

中村先生の研究室のデータベースには1300万もの日本語と英語の対訳用例が入っている、という。それほど膨大でなくても、私たちが旅先でする程度の会話なら文の長さは平均して7単語程度、使われる単語の種類も多くはないので、音声翻訳も比較的容易だ。すでに、いくつかのサービスが実用化され始めている。また、東京オリンピックの開催が研究を加速。2020年の完成を目指した関連技術の開発のニュースも聞こえるようになってきた。

東京オリンピックまでに医療分野での自動翻訳を実現するといったニュースもありますが、これなどは必要性の面でも重要ですし、病院で使われる言葉は比較的限定されますから、実現の可能性はかなり高いでしょう。日本を訪問した外国の方が自分のスマホに専用アプリを入れるか、あらかじめ病院の端末などにダウンロードしておくだけでいいので導入も容易。英語だけでなく、中国語や韓国語など複数の言語で対応できるようになる、と思います。

さて私ですが、2020年代を目標に日本語と英語の同時通訳を実現したいと考えています。

みなさんもテレビのニュース番組などで、外国の人が話している内容を、ほとんど間を置かずに日本語に翻訳している様子を見たことがあるでしょう。あれが同時通訳で、同時通訳は特別な訓練を受けた人だけができる「特殊な技能」といえます。高い語学力はもちろん、判断力や集中力も要求され、それだけ高度なことを機械にさせるわけですから、簡単ではありません。しかし、これを実現できれば世の中は大きく変わります。

実現までに越えなくてはいけない壁はいくつもあるのですが、たとえば「日本語から英語」で見てみると、語順の違いが大きい。日本語の語順は「主語+目的語+動詞」、一方、英語は「主語+動詞+目的語」で、日本語では最後まで聞かないと肯定か否定か判断できません。その分、英語への翻訳を始めるまでに時間がかかってしまいます。レベルの高い同時通訳を実現するには、こうした語順の違いを乗り越える、まったく新しい手法が必要になります。

そこで、私たちは「フレーズ」の段階で翻訳をスタートし、並行して語順の並び替えの確率を予測する方法を開発しました。スピードを早めても精度が低くならないような工夫を凝らしています。すでにこの方法で、同時通訳を始めて1年目くらいの人と同等の能力をもつレベルに達することができています。さらに、熟達した人のレベルに達すべく、語順の並べ替え確率などのデータ収集を進めて精度を高めているところ。ベテラン同時通訳者のコツやテクニックなども研究し、それらも盛り込んでいく予定です。

語順以外にも、テキスト化された文章にはない、「言い間違え」や「文法的な間違い」を適切に汲み取って反映させる技術も必要です。「行間を埋める」といったこともできるようにしなくてはいけません。さらにいえば、日本語にはあるけど他の言語にはない言葉や表現をどうするか? たとえば「色の名前」など日本語は他の言語に比べて極めて豊富だといわれますが、目的の言語にあてはまる色の表現がない場合は、自動的にインターネットを通じて情報を集め、適切な言葉を当てはめる。そんなことができるようにする必要もあるでしょう。

いずれも非常に大きな壁ですが、決して乗り越えられないものではないと思っています。

音声翻訳技術を社会のさまざまな場面に活かす

音声翻訳は1980年代から研究が始まった。以来、日本が最先端を走っている。理由は日本の技術力に加え、「ニーズが非常に高い」からだ。早くも80年代に、国の後押しで基礎研究を行う組織(国際電気通信基礎研究所=ATR)が誕生、中村先生もその研究員として活躍した。いまでは、国内のさまざまな大学、研究所、企業が自動翻訳の研究・開発に取り組んでいる。海外でも欧米を中心に盛んだ。そう遠くない将来、地球から「言葉の壁」はなくなるかもしれない。

先ほど語順の問題についてお話しました。その点では、お隣の国で使われている韓国語は日本語と類似しており、英語に比べ機械による同時通訳の難度は低いといえます。モンゴル語、トルコ語も日本語によく似ています。とはいって、対訳データが少ない。韓国語はまだしも、モンゴル語、トルコ語に関しては圧倒的に不足しています。対訳の質と量から「日-英」を先行させていますが、英語以外の言語へのアプローチも進めていかないといけないでしょう。

そうした取り組みが、世界中で行われるようになると、地球から「言葉の壁」がなくなる。スマートフォンひとつあれば、世界中の人たちと会話を楽しめるような日が必ず来るはずです。どうです? 素晴らしいと思いませんか。

音声翻訳の応用範囲は広くて、コミュニケーション障害の人たちの支援にもなります。われわれはそうした人たちがコミュニケーションの訓練をするためのシステムも開発しました。機械を相手に行う会話を評価し、うまくコミュニケーションができるように導いていく、というものです。いまは臨床心理士や医師といった専門家が訓練を行っていますが、これを使えば手軽にトレーニングができます。また、音声合成の技術がもっと発達すれば、声を失った人に元の声を取り戻してあげるといったことも可能になるでしょう。これも現在研究中。こちらは外国語の発声を補正するといった語学教育にも活かすこともできる、と考えています。

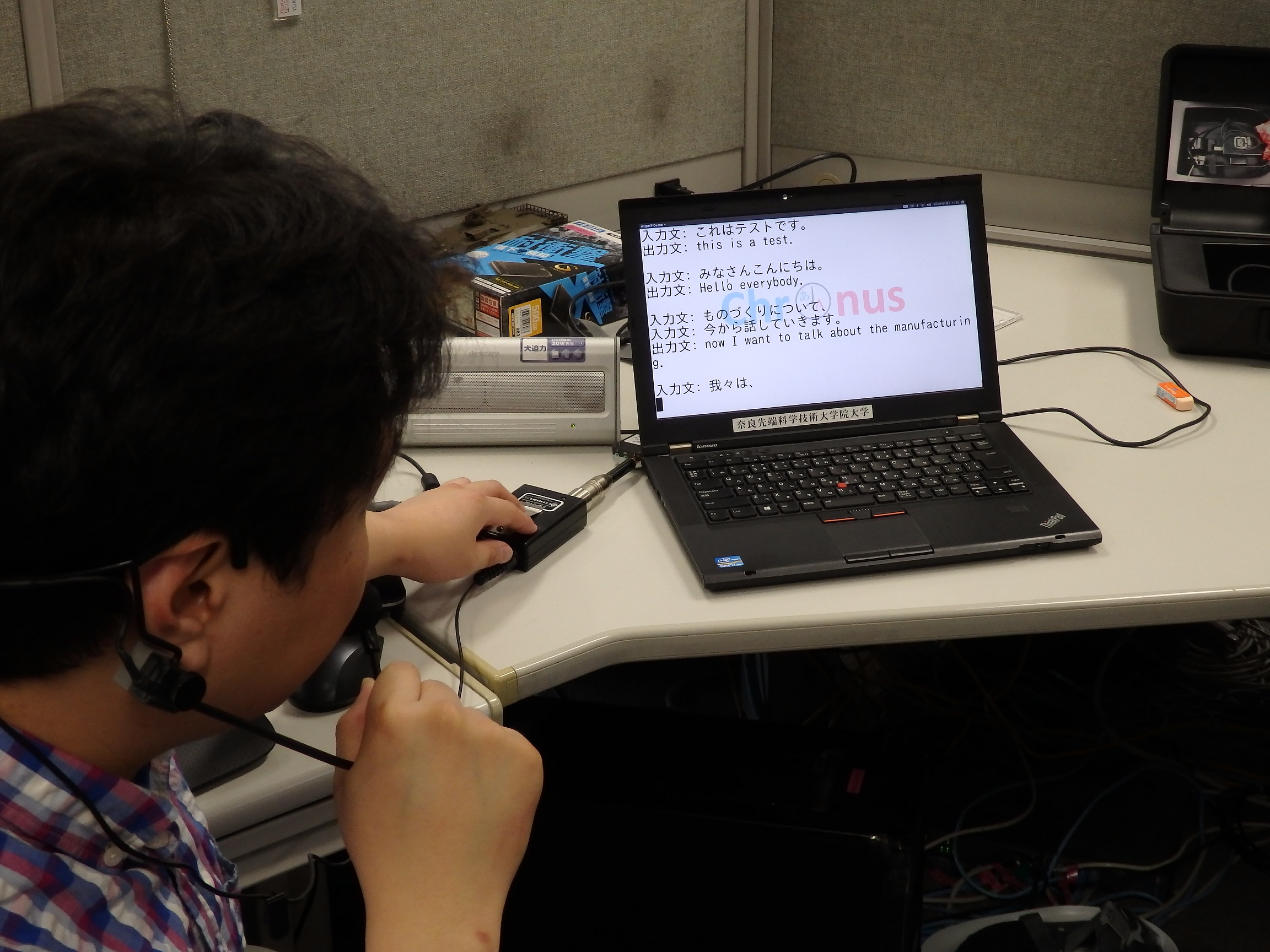

とにかく、すべきことがたくさんあって大変(笑)。でも、やりがいはすごく大きい。私の研究室の大学院生もみな活き活きと研究に取り組んでいます。

もしかしたら、この記事を読んで興味をもってくれた人もいるかもしれませんね。「自分で自動翻訳の機械をつくってみたい」という人がいたら大歓迎! ぜひ、飛び込んでください。そんな人にアドバイスするとすれば、冒頭でも述べたように「とにかく中学生・高校生の間はしっかりと英語を勉強してください」ですね。そして数学、物理の勉強も怠らないこと。専門的な知識はあとになっても身につけることができます。しかし、その土台となるものを築けていなければいい研究はできません。頑張ってください。

《文=WAOサイエンスパーク編集長 松本正行》